“國際社會應確立具體、可操作、受全球認可的紅線,確保人工智慧系統在任何情況下均不得逾越。”7月25日, 由傑弗裏·辛頓(Geoffrey Hinton)、姚期智、本吉奧(Yoshua Bengio)、斯圖爾特·羅素(Stuart Russell)等20餘位行業專家、學者共同簽署的AI安全國際對話上海共識(以下簡稱“上海共識”)正式對外公開。

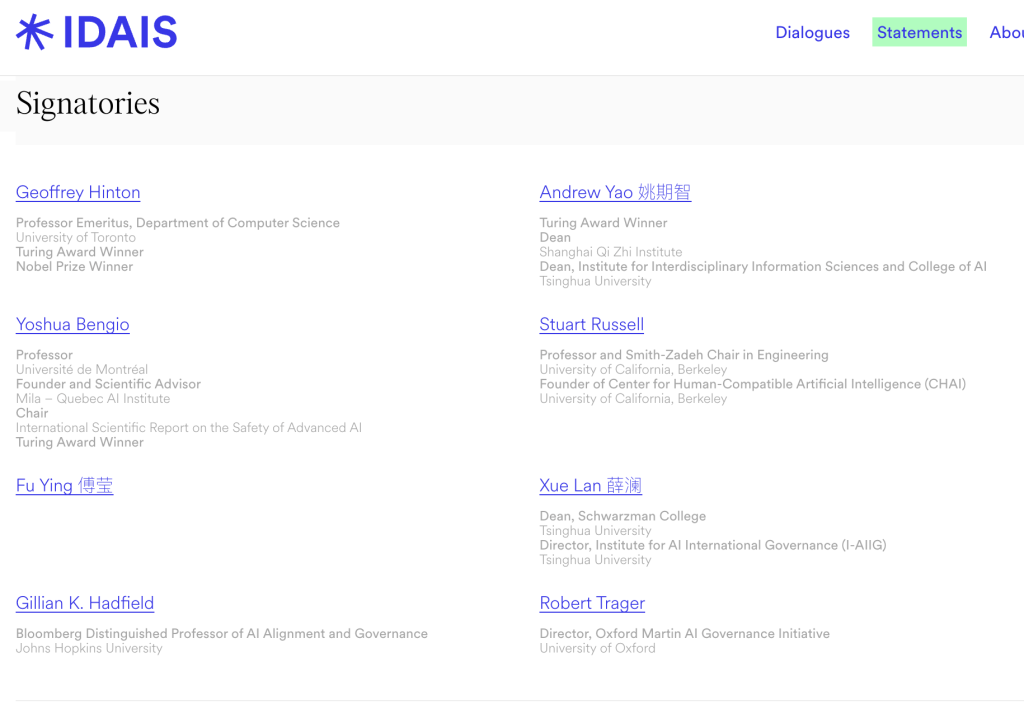

參與簽署的部分中外科學家 來源:IDAIS官網

此次對話是“AI安全國際對話”(International Dialogues on AI Safety – IDAIS)系列的一部分”。作為本次共識發起方之一,圖靈獎得主、上海期智研究院的院長姚期智當日表示,“我越來越相信,人類終將找到解決方案。”

2024年3月,辛頓、姚期智、羅素、本吉奧等專家曾共同簽署“北京共識”,主張限制AI系統複製、欺騙、武器開發等行為,尤其呼籲行業為AI的研發和應用戴上“緊箍咒”,避免相關技術被濫用,推動全球治理機構構建。姚期智透露,18個月前舉辦第一次安全共識會議時,AGI強大的破壞力就已經顯現,人類甚至難以闡明其失控機制,不過隨著相關會議的推進,已經看到若干有關基於“設計的安全”(Safe by design)提案,這意味著實際上人類可以找到確保AI安全的可行路徑。

此次“上海共識”指出,當前人類正處於一個關鍵轉捩點:人工智慧系統正迅速接近並可能超越人類智能水準。這些未來的系統可能在操作者毫不知情的情況下,執行並非操作者所期望或預測的行動。這可能導致失控,即一個或多個通用人工智慧系統脫離任何人的控制,從而帶來災難性甚至是生存層面的風險。當前,對於能夠在更高級的通用人工智慧超越人類智能水準後,仍可靠地確保其對齊,並保持人類的有效控制尚無可行方法。

多位與會專家在參與討論時也提及,當前構建真正有約束力且值得信賴的國際AI安全框架難度高、風險大。

上海人工智慧實驗室主任周伯文教授指出,目前Make AI Safe(使得AI安全)最大的問題在於它是事後價值對齊、修補的、被動回應的,通常是防禦成本過高而攻擊成本過低。而Make Safe AI(構建安全的AI)是主動的、線上共同演進的,同時防禦成本低,能夠在各級風險上都保持應變能力。

周伯文認為,在一定程度上,訓練一個模型變得友善和訓練一個模型變得聰明可能是兩條不同的技術路徑。但當性能發展到某個程度,這兩種能力可能很難分開處理——就像經典牛頓定律可以有效解釋靜止或慢速物體的運動,但是一旦逼近光速,這套理論就失效了。所以他認為,下一代模型的“善”與“智”未必能完全獨立、分開發展,而是相互影響、共同進化的。

參與簽署的專家之一,擔任約翰·霍普金斯大學人工智慧對齊與治理方向傑出教授吉莉恩·哈德菲爾 (Gillian Hadfield)在接受包括澎湃科技在內的媒體採訪時指出,必須通過設立AI“紅線”來推動Make AI Safe(使得AI安全),全世界需要跨國界合作。此外,要建立相應的AI安全合規系統。

為防範與糾正此類行為的技術路徑與治理機制,“上海共識”提出應對策略,並呼籲採取三項關鍵行動:要求前沿人工智慧開發者提供安全保障、通過加強國際協調,共同確立並恪守可驗證的全球性行為紅線、投資基於設計的安全人工智慧研究。

其中,對於開發者來說,“上海共識”要求開發者在模型部署前應先進行全面的內部檢查和第三方評估,提交高可信的安全案例,以及開展深入的模擬攻防與紅隊測試。若模型達到了關鍵能力閾值(比如檢測模型是否具備幫助沒有專業知識的非法分子製造生化武器的能力),開發者應向政府(在適當時亦可向公眾)說明潛在風險。

此外,呼籲國際社會需要合作劃出人工智慧開發不可以逾越的紅線(即“高壓線”),這些紅線應聚焦於人工智慧系統的行為表現,其劃定需同時考量系統執行特定行為的能力及其採取該行為的傾向性。為落實這些紅線,各國應建立一個具備技術能力、具有國際包容性的協調機構,彙聚各國人工智慧安全主管機構,以共用風險相關資訊,並推動評估規程與驗證方法的標準化。

“上海共識”指出,短期內亟須建立可擴展的監管機制以應對人工智慧的欺騙問題、提升模型對“越獄”等攻擊手段的抵禦能力、強化資訊安保投入等,而長期則需要一個“基於設計的安全”的架構,而非問題出現後才被動應對。

來源:中國澎湃新聞

您當前的位置 :

您當前的位置 :