- ·也許有一天,AI編舞師可以根據你的腦回路特徵,為你量身定制一支最能打動你的舞蹈。

當我們欣賞一段舞蹈時,大腦如何將視覺上的動作與聽覺上的旋律融合成一種名為“美”的體驗?這是神經科學中最具挑戰性的問題之一,原因在於科學家們缺乏一把能衡量“藝術感”的尺子。

隨著人工智慧(AI)技術的發展,這個困境有望被一種新的方法論所突破。在一項新研究中,研究者另闢蹊徑,先構建了一個“懂舞蹈”的人工智慧,然後用這個AI作為“解碼器”,反向破譯了人腦的神經活動。該研究於11月19日發表在《自然·通訊》(Nature Communications)雜誌上,作者來自東京大學、大阪大學及日本資訊通信研究機構(NICT)。

研究團隊使用的這個名為“EDGE”的跨模態AI模型可以被想像成一位學習了海量數據的“編舞師”。它不僅能“看懂”舞者的動作,還能“聽懂”背景音樂的節奏和旋律。通過深度學習,這個AI的任務是根據過去的動作和當前的音樂,預測下一個最和諧、最自然的舞步。

研究者們提出了一個假設:如果這個AI為了生成優美的舞蹈而形成的內部表徵(即它對“動作-音樂”關係的理解),恰好與人腦處理這些資訊的方式不謀而合,那我們不就能用AI的“語言”來“翻譯”大腦的活動了嗎?

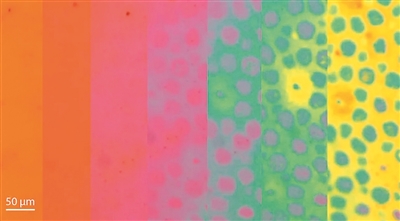

在實驗中,研究人員首先邀請了專業舞者和舞蹈新手,讓他們躺在功能性磁共振成像(fMRI)掃描器中,觀看了長達五小時的涵蓋街舞、爵士舞等多種風格的真實舞蹈視頻。同時,研究人員提取了AI模型中負責整合音樂和動作的跨模態特徵,並將這些數學參數與fMRI成像數據進行比對。

結果顯示,AI提取的“視聽融合”特徵,比單純的“動作特徵”或“音樂特徵”能更準確地預測人類大腦的活動。這意味著我們的大腦在欣賞舞蹈時,不是把視覺和聽覺做簡單的加法,而是在高級視覺區和聯合皮層(如前額葉和頂葉)進行了一場複雜的跨感官神經活動,將動作與音樂融合成了一個整體的體驗。

通過AI“讀心術”,研究還探究了哪些舞蹈概念與哪些區域的大腦活動相關。例如,充滿活力的舞蹈能顯著啟動大腦中與自我意識相關的“默認模式網路”,而被評價為“無聊”的舞蹈則會抑制這些區域的活動。這或許解釋了為何引人入勝的藝術能讓我們暫時忘記自我,而乏味的表演則讓思緒飄忽不定。

這項研究不僅加深了我們對藝術審美的神經機制的理解,也為一種“神經美學”應用提供了可能:也許有一天,AI編舞師可以根據你的腦回路特徵,為你量身定制一支最能打動你的舞蹈。

來源:中國澎湃新聞

您當前的位置 :

您當前的位置 :