告別物理幻覺:首個全模態物理AI基礎模型OmniFysics問世

2月9日,飛捷科思智能科技(Fysics AI)聯合復旦大學認知智能技術實驗室(CITLab)正式發佈了全球首個面向真實物理世界的全模態物理AI基礎模型——OmniFysics。該模型旨在解決當前生成式AI普遍存在的“物理盲”問題,即雖然能夠生成高質量圖像或對話,但在處理涉及重力、材質、密度等物理規律時常出現違背常識的“幻覺”。

不同於傳統大模型依賴海量視覺數據進行模式匹配的路徑,OmniFysics在僅有3B參數量的輕量化架構下,引入了物理感知與因果推理機制。通過“靜態中樞(FysicsAny)”與“動態中樞(FysicsOmniCap)”兩大獨創數據生態,該模型能夠識別物體的物理屬性(如陶瓷的硬度、水的流動性)並理解視聽結合下的物理因果(如撞擊聲與材質的關聯)。這種機制使得AI不僅僅停留在像素層面的生成,而是深入到了物理參數的反演,能夠精准預測如密度、楊氏模量等仿真參數。

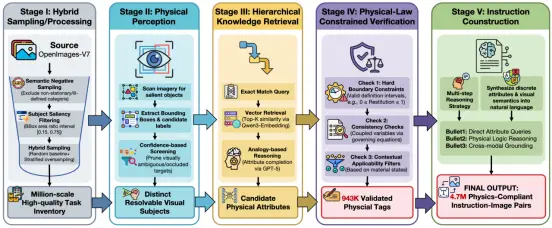

物理數據中樞示意圖

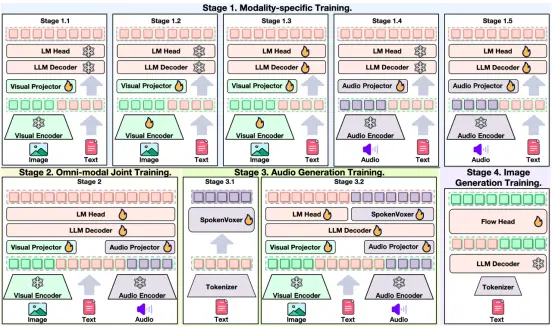

在技術架構上,OmniFysics採用了四階段漸進式訓練法,先獨立訓練單模態感知,再進行全模態深度融合,有效平衡了單一任務的專業性與跨模態的協同能力。為驗證模型的實際物理理解水準,團隊同步推出了FysicsEval評測基準。

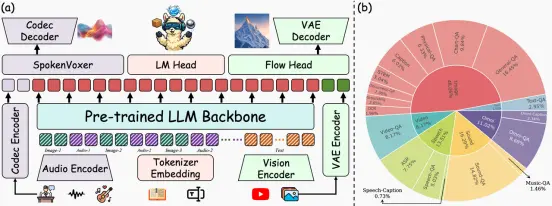

OmniFyscis模型框架示意圖

OmniFysics的四階段訓練流程

這是一套涵蓋物理屬性預測、物理邏輯推理及跨模態一致性判斷的綜合評估體系,旨在考核AI是否具備識破“水往高處流”等違反物理常識現象的能力,為具身智能從語義理解邁向物理交互提供了量化尺規。

來源:中國IT之家

您當前的位置 :

您當前的位置 :