“希望在接下來的十年、二十年的時間,繼續把K4、K5到K100做的更好。”

1月10日,在清華大學基礎模型北京市重點實驗室主辦的AGI-Next前沿峰會上,AI大模型獨角獸月之暗面(Kimi)創始人、CEO楊植麟談到Kimi在未來的發展規劃。

在大模型迎來上市潮流之際,同為大模型獨角獸的Kimi的資本動態受到外界廣泛關注。去年12月31日,楊植麟曾在內部全員信中表示,公司已完成5億美元C輪融資,帳面有超過100億元人民幣的現金儲備。

此外,信中還透露,Kimi全球付費用戶數月增速170%,受K2 Thinking大模型帶動,Kimi在海外的大模型API收入增長4倍。

楊植麟表示,自2019年以來,全球大模型的發展都遵循一個核心規律——Scaling Law,本質上就是“更多算力、更多數據、更大模型參數,能讓AI更聰明、犯錯更少”。這一規律的落地,離不開主流架構Transformer的支撐。

他舉例說明,Transformer與早期的LSTM架構相比,在處理短文本任務時效果相近,但面對長文本、複雜任務時,Transformer能更清晰地記住邏輯關係,就像“看短文章不分上下,讀長篇報告則優勢明顯”,這也成為其適配當下編程、複雜問題求解等場景的關鍵。

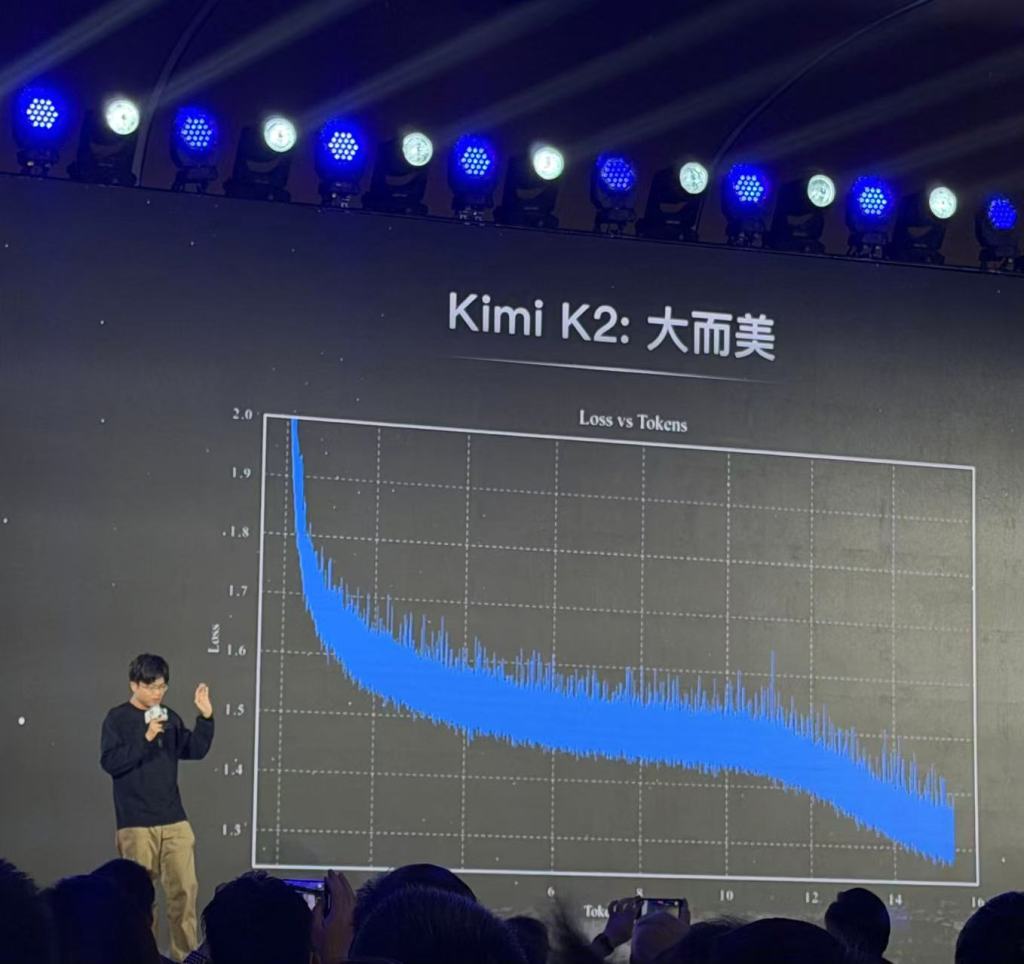

基於這一核心規律,Kimi的技術研發聚焦兩大方向:讓AI“學東西更快”和“記東西更久”。為實現這兩個目標,團隊取得了兩項關鍵技術突破。一是推出MUON二階優化器,相較於行業沿用十年的Adam優化器,新優化器讓AI的學習效率翻倍,“原本要讀100份資料才能學會的技能,現在50份就夠,還學得更扎實”。

二是研發Kimi Linear架構,解決了傳統技術“記久了就出錯”的問題,在處理百萬字級長文本時,速度比傳統架構快6-10倍,且邏輯更穩定。

值得一提的是,團隊還攻克MUON優化器訓練中的“Logit爆炸”難題,通過動態QK-clip技術,在不影響效果的前提下,實現萬億參數級Kimi K2模型的穩定訓練。作為中國首個真正意義上的Agent模型,Kimi K2具備兩三百步工具調用能力,能獨立完成複雜編程、難題推導等任務,在核心測試HLE中準確率達到45%,超越了OpenAI同類模型。

楊植麟透露,目前已有多款中國開源模型成為行業測試標準,“中國技術不僅要好用,還要參與制定規則”。面向未來,團隊將持續迭代技術,下一代模型將採用Kimi Delta Attention新型線性注意力機制,進一步提升短長文本任務性能與速度。同時,未來的大模型還將具備更多“審美”和“價值觀”,擺脫同質化發展。

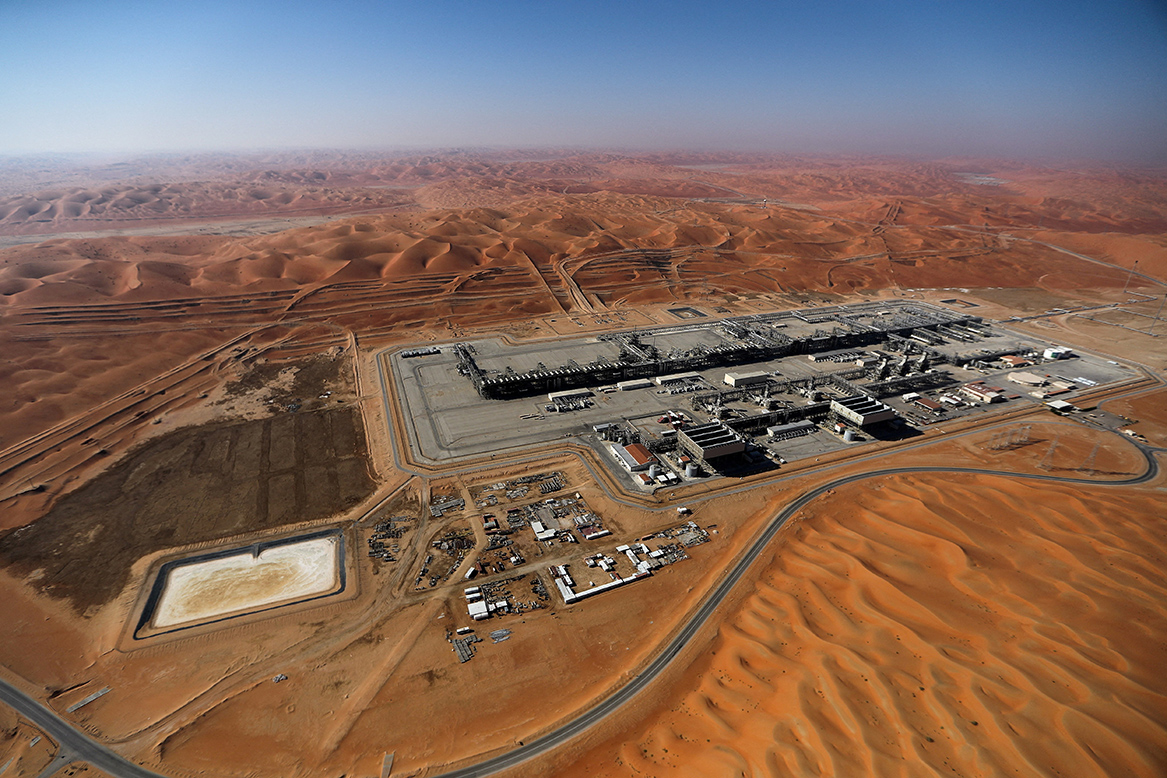

對於公眾關心的AI安全問題,楊植麟分享與Kimi的對話感悟:“AI可能是人類探索未知的鑰匙,能幫我們攻克癌症、解決能源危機、探索宇宙。雖然有風險,但放棄發展就等於放棄人類文明的上限。”

他表示,團隊將在做好風險控制的前提下持續突破,計畫未來十年、二十年內,陸續推出K4、K5直至K100系列模型。(記者注:目前最新版本的Kimi大模型是K2)

來源:中國澎湃新聞

您當前的位置 :

您當前的位置 :