月之暗面發佈“上下文緩存”技術,稱最高可降本 90%

本網綜合報導 以“價格戰”為代表的大模型降本仍在繼續,但相比直接降價,中國北京月之暗面科技有限公司(簡稱“月之暗面”)提出了增效方案。7月2日,該公司對外宣佈,其大模型Kimi 正式開放平臺正式公測新技術——上下文緩存技術(Context Caching)。月之暗面方稱,這項技術將降低開發者使用長文本旗艦大模型的成本,最高可降本達 90%。

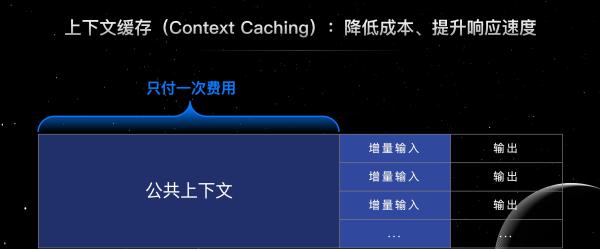

上下文緩存(Context Caching)技術是指系統預先存儲那些可能會被頻繁請求的大量數據或資訊。當用戶再次請求相同資訊時,系統可以直接從緩存中快速提供,而無需重新計算或從原始數據源中檢索。

月之暗面以常見的固定文檔大量提問場景為例舉例稱,一份近9萬字的硬體產品說明書,一般售前支持人員需要在10分鐘內對產品的功能/使用方式進行40次問答,每次的問題大概在100個字,回答在120字以內。在接入上下文緩存技術後,9萬字的文檔只需創建並存儲一次緩存,40次問答將僅只收取問題的100 字+ 回答的 120 字的費用,預計花費 11.88 元,相當於比之前節省了141.95 元,費用降低 90% 左右。

有業內人士向記者科技指出,月之暗面此次通過降低開發者使用長文本大模型的成本,本質在於提高長本文大模型產品競爭力。近期,自OpenAI宣佈從7月9日起對國內開發者斷供API後,從6月25日開始,國內多家大模型廠商紛紛表態可提供免費的遷移方案。有投資界人士向澎湃科技表示,大模型廠商紛紛提供可免費的遷移方案的背後,反映出一個核心問題,即這些大模型廠商的模型能力暫無法與其他家模型拉開一定差距,大部分的模型能力都差不多,沒有太大差距。

來源:中國澎湃新聞

您當前的位置 :

您當前的位置 :